智能对话系统知识库的设计与实现

引言

智能对话系统是一种通过自然语言进行人机交互的系统,作为一种新型的人机交互方式,是人工智能领域的重要研究内容。自然语言理解是人机交互的重要组成部分,而对话系统知识库的设计与实现是其中的关键。因此智能对话系统知识库的设计与实现有着重要的研究意义和应用价值。完善的知识库不仅可以解决智能对话系统理解能力差、回答问题呆板等缺陷,还能主动感知用户的需求并提供相应服务。

在大量智能对话系统实际落地过程中发现,运营人员对智能对话系统知识库设计与实现缺乏系统方法及正确的质量评测标准。为此本文从人工智能训练师角度较总结了智能对话系统知识库设计与实现的方法,引导智能对话系统更好地理解用户意图,并提出了质量评测指标及相应的提升方案,对智能对话系统的搭建具有一定的指导和参考意义。

智能对话系统知识库的设计与实现

1、需求分析

需求分析是智能对话系统知识库设计的基础。需求分析可以提炼客户真实需求,了解客户业务重点,同时也可以让客户更好的理解对话系统的架构及运作模式。客户需求一般分为业务需求和功能需求。业务需求即系统需要实现的目标。功能需求,为实现业务目标系统必须具备的功能。

无论是业务需求还是功能需求,客户更多是从自身情况提出的。需要将客户需求结合产品功能,应用到实际交互场景中,剔除伪需求,才能制定出满足客户真实需求的设计方案。客户伪需求主要有以下几个特征:

(1)业余的表达;

(2)使用频率低,违背产品定位;

(3)影响用户体验;

(4)现有产品功能无法实现,但可用其他方案替代。

在明确了客户的真实需求后,还需要根据当前标准产品的系统功能,划分功能需求优先级。优先开发可作为标准产品、开发所需成本较少、能够消除更多风险的新功能。

2、智能对话系统知识库的设计与实现

智能对话系统通过智能对话管理模块确定业务对话范围。智能对话管理模块相当于智能对话系统的知识库,它由标准问答数据、训练数据、测试数据三大要素组成。下面进行详细介绍。

标准问答包含标准问题和标准答案,用户最常问的问题经过归纳整理之后就形成了标准问题。一个标准问题代表了一系列用户会问到的意思相近,可以用一个标准答案来回答的问题。标准问题对应的答案即标准答案,即用户得到的回复,标准答案必须直接回答客户问题或给出明确指引,不能引发用户疑问或者反问。

由于企业提供的业务知识无法直接用来给机器人学习,需要将业务知识整理成机器可学习的标准化数据,即标准问答数据,它能帮助机器人更加准确识别语义。设计标准问题时需要遵循三大原则:

1.标准问题覆盖范围广;

2.业务知识没有遗漏,标准问题之间没有重复;

3.标准问题只表达一个句意。

训练数据能够帮助算法建立模型,是机器学习非常重要的数据。训练数据的质量越高,训练模型的效果就越好,准确率也就越高。一般每个标准问题需要准备20-30条训练数据,可以通过标注或扩写的方式提供。标注指的是对前期用户log进行标注,标注数据时需要统一标注标准。扩写指的是模拟真实用户,将同一个标准问题用不同的表达问法撰写出来,扩写训练数据时需要注意以下几点:

1.优先覆盖简单的、通用的、高频问法;

2.覆盖不少于5个标准问题主要知识点;

3.避免冗余和无效扩写;

4.不要超过25个字。

对经过训练后的机器人数据做质量检测的数据叫测试数据。质量检测结果即正确率,是决定机器人上线重要标准之一。测试数据设计的好坏会影响到检测结果,测试数据通常来源于用户前期log数据或人工扩写。为了确保测试数据的客观性,如果使用用户前期log数据进行测试,需要检查测试数据的标注标准是否统一,如果人工扩写测试数据,则需要注意以下几点:

1.尽可能贴近真实用户问法;

2.对应正确标准问题;

3.没有与训练数据重复;

4.测试数量要足够。

3、智能对话系统知识库的优化

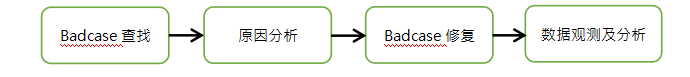

智能对话系统的质量检测需要达到一定的正确率标准,才能正式上线为客户提供服务。正确率不达标时需要对Bad Case数据进行优化。机器未解答,解答错误或解答不够好的数据即Bad Case。Bad Case优化流程如图1。

图1 Bad Case优化流程

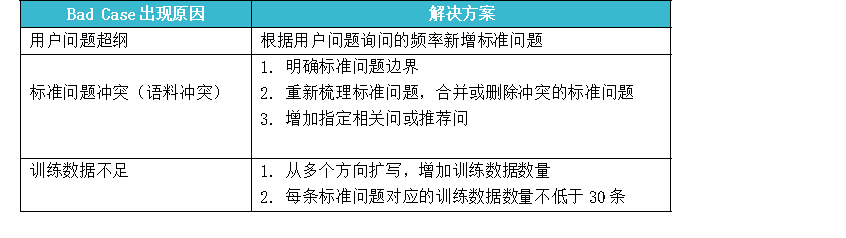

Bad Case产生的原因主要有三个:用户问题超纲、标准问题冲突、训练数据不足。需要根据Bad Case产生原因设计相应解决方案,如表1所示。同时优化之后还需要复测Good Case是否受到影响。

表1 Bad Case出现原因及解决方案

智能对话系统质量的评测及提升

1、智能对话系统质量的评分指标

智能对话系统的质量需要有合理的度量标准来评价。好的评价标准能指引对话系统发展的方向,提供满意的服务。一般来说,性能良好的智能对话系统需要具备语义相关度高、信息量丰富、表达方式多样的特点。当前智能对话系统的评价方法主要是人工评测,评测指标包括应答能力、接待能力、服务满意度等。

(1)应答能力

应答能力是对话系统基础功能也是重要价值指标,用于评估已上线机器人与真实业务场景的贴合程度,主要通过业务识别率和业务准确率两方面来度量。业务识别率考察系统找全回复的能力,而业务准确率考察系统找准回复的能力,两者相辅相成,从两个不同侧面较为全面地反映系统性能。业务识别率和业务准确率可用下式计算。

业务识别率=(总提问量-总拒识量-闲聊识别量)/总提问量

业务准确率=业务识别正确量/业务总量

(2)接待能力

接待能力用于评估已上线机器人对人力的取代程度,是企业决定使用对话系统的关键指标。用户与机器人进行多番交互后,问题仍然得不到解决用户就会转人工。提升接待能力能够提高人工效率,节省人工成本。

基于有效会话及有效转人工数据计算拦截率,能够客观地反应机器人接待能力。用户进入场景后没有对话直接退出场景,或直接要求转人工以及类似这种的机器人无法拦截的会话,都属于无效会话。其中用户进入场景后直接要求转人工的会话属于无效转人工会话。拦截率可用下式计算。

拦截率=1-[(总转人工会话量-无效转人工会话量)/(总会话量-无效会话量)]

(3)服务满意度

服务满意度即用户对机器人回复满意程度。服务满意度的评分方式有满意度评分和点赞/点踩率,可分为整体会话的满意度评分和点赞/点踩率及单个答案的满意度评分和点赞/点踩率。具体采取哪种评分方式,取决客户要求。由于多数用户在得到满意回答后,不习惯进行评价直接退出场景,而得到不满意回答后更倾向留下差评,所以差评数可以更客观的评价服务满意度。满意度可用下式计算。

满意度=1-差评数/总会话量

2、智能对话系统质量的提升

(1)应答能力的提升

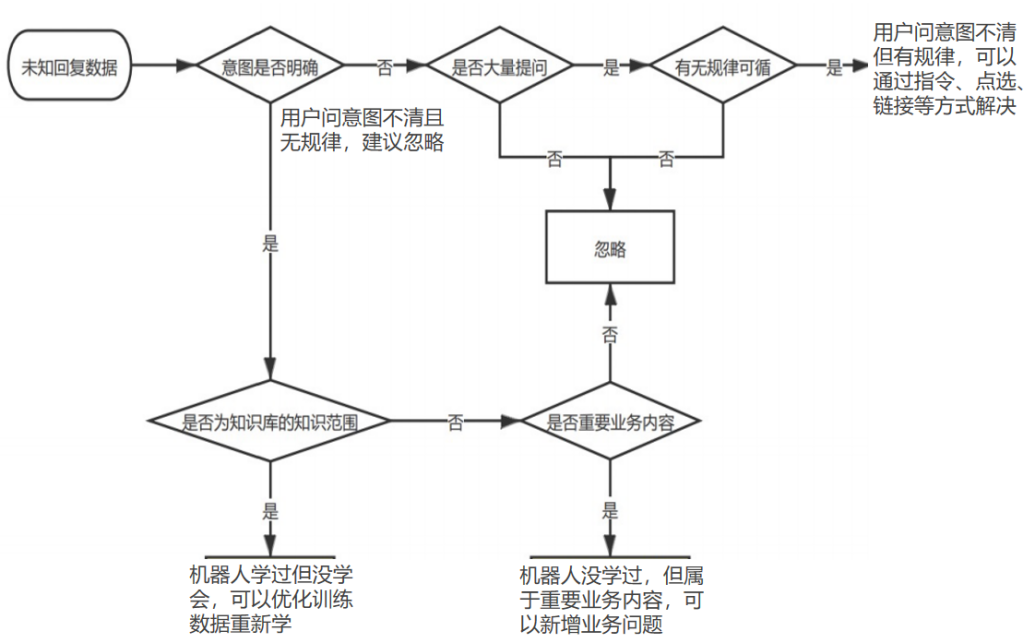

提升应答能力可提升对话系统解决问题的能力。通过业务识别率公式可以看出,降低拒识问题占比也即降低未知回复数据就可以提高业务识别率,未知回复数据出现的原因及对应的提升流程如图2所示。

图2 未知回复数据出现的原因及对应提升流程

(2)接待能力的提升

通过用户日志分析不同场景用户意图与需求,可以采用以下策略提升接待能力:

a.安抚场景,需要在答案中多给用户肯定信息,避免用户转人工二次确认;

b.操作场景,需要考虑通过多轮交互的方式解决用户问题;

c.触发敏感词或者转人工才能解决的特殊场景,需要配置转人工策略;

d.用户问法过细,有相近标准问但答案无法解决问题,需要修改现有标准问题的范围及对应答案。

(3)服务满意度的提升

满意度指标相对主观,交互方式不友好,机器人回复太死板,用户问题未解决等都会影响用户使用体验。指标本身不能指明改进方法,需要通过调研听取用户声音,了解用户使用感受,有针对性优化满意度。可采取的调研方法有:

a.机器人页面调研,在用户提交差评的同时让用户选择不满意的原因;

b.电话调研,选择机器人回答正确依旧转人工的用户进行人工回访,询问选择人工的具体原因;

c.其他通用的短信、邮件调研。

结束语

本文从人工智能训练师角度出发,详细阐述智能对话系统知识库的设计与实现,具体包括项目实施前的需求分析,智能对话系统知识库三大要素的设计、实现及优化思路。然后总结了一套智能对话系统质量评测指标,以及相应的提升系统质量的方法。这些为智能对话系统训练师建立了一套较完整的方法论,对智能对话系统的搭建具有一定的指导和参考意义,能够有效提高对话系统的智能性。

作者:彭凡;单位:竹间智能科技有限公司。

本文刊载于《客户世界》2022年4月刊。

转载请注明来源:智能对话系统知识库的设计与实现

噢!评论已关闭。